WEBサイトって、丸ごとコピーしてオフラインで読みたいっことありませんか?

この種のサイトでは、

っていう有名なサイトがありますが、これは画面キャプチャーなんでしょうか。

ちょっと趣旨が違うので調査は行いませんでした。

さて、それではWEBサイトを丸ごとダウンロードしてローカルに保存する方法を調べてみました。

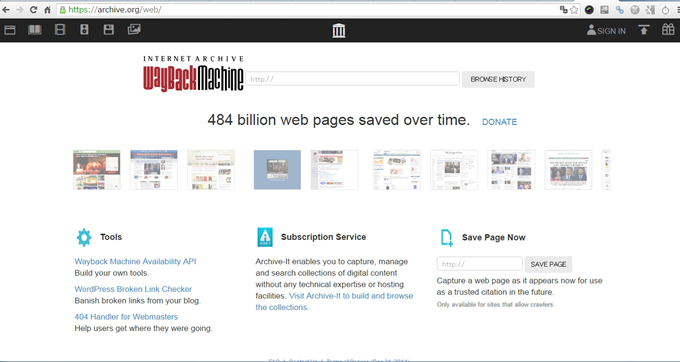

Internet Archive: Wayback Machine

インターネットの過去のアーカイブサイトとしては、

が有名ですね。

このサイトって情報を取得するAPIを用意しているようです。

Wayback Machine APIs

The Internet Archive Wayback Machine supports a number of different APIs to make it easier for developers to retrieve information about Wayback capture data.

The following is a listing of currently supported APIs. This page is subject to change frequently, please check back for the latest info.

Updated on September, 24, 2013

ただ、ちょっと敷居が高いのでもう少し簡単にスナップショットをダウンロードする方法を調べてみます。

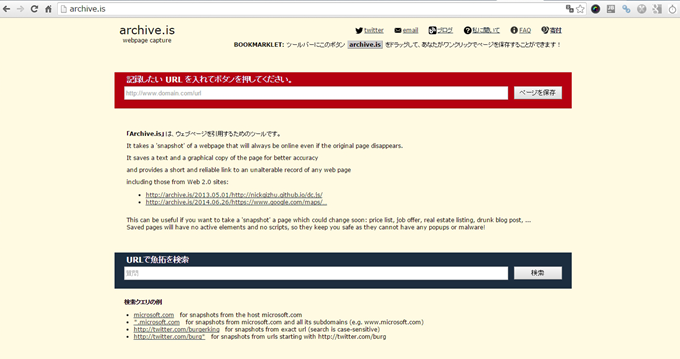

archive.is webpage capture

もウェブ魚拓同様にWebサイトをキャプチャするんでしょうか?

URLを入力して「ページを保存」してダウンロードしてみます。

ページを次々にキャプチャして画像に保存しているようです。

ただ、保存されたファイルをダウンロードしようとすると、Gateway Timeout。。。。。

ページの画面イメージを見たいわけでもないし、あきらめました。

やっぱり wget が最高

プログラム寄りになってしまいますが、やっぱり、WEBサイトを丸ごとコピーするなら

wget

が最高です。

具体的には以下のようにして使います。

|

1 |

# wget -r -l 0 http://(取得したいURL)/ |

-r –recursive ということで、再起的に取得する。

-l –level リンクをたどる階層数を指定する。デフォルトは5階層で、0を指定すると全階層。

このようにすると、ローカルに丸々HTMLやらCSSやら画像やら、WEBサイトが丸ごとコピーしてダウンロードされます。

ネットから切断されたローカル環境でWEBサイトをゆっくり見るならこの方法が一番簡単です。

私の場合、Cygwin のwgetを使っています。

Cygwinについては以下をご覧ください。

wgetだけを使いたい人は、以下のwgetが使えるかもしれません。

この記事、お役に立てば、シェアして頂けると嬉しいです。

コメント